Towards Understanding the Gaps of Offline and Online Evaluation Metrics: Impact of Series vs. Movie Recommendations / RecSys24

실험 결과

- 기존 모델: EASE (shallow autoencoder 기반 CF)

- 신규 모델: AE-Boost

- EASE 점수 + 아이템 인기도 + 메타데이터 + 유저-아이템 피처를 사용한 XGBoost 스태킹 모델

- 오프라인 결과: NDCG, Recall에서 EASE 대비 대폭 개선 (특히 Top-7)

- 그런데 온라인 A/B 테스트 결과: 시청 시간(ED), 방문 빈도(SF)는 유의미한 개선 없음, 다양성 지표(Catalog Depth)만 소폭 증가

핵심 발견

- AE-Boost는 시리즈 추천 비율이 EASE보다 약 26% 낮음

- 가설

- 시리즈 추천 1건은 영화 추천 1건보다 가치가 큼 (연속 시청 → 더 긴 시청 시간, 더 많은 방문)

- 영화 위주 추천은 시청 후마다 의사결정 부담(cognitive load)을 증가시킴

- 즉, 무엇을 잘 맞췄다보다 무엇을 추천했는지가 온라인 비즈니스 성과에 더 중요

해결 방법

해결 방법

- 손실 함수에 시리즈 가중치 w_s를 도입한 AE-Boost-S 모델 제안

- 시리즈 샘플의 positive loss를 더 크게 반영해 Top-K 내 시리즈 비율을 조절

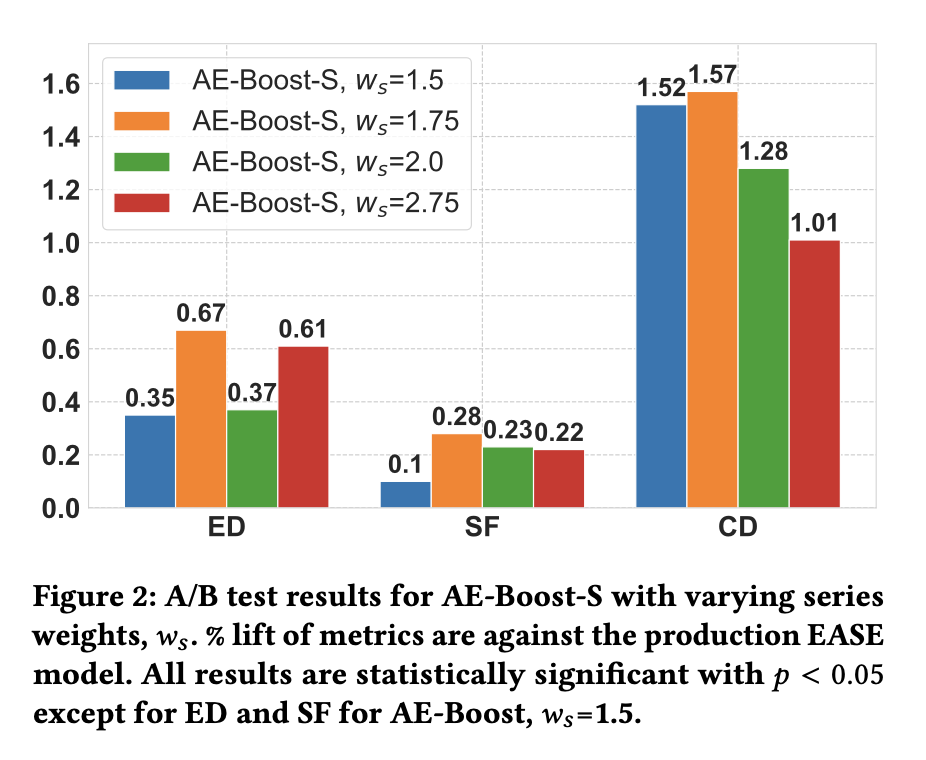

- w_s 증가 → 시리즈 추천 비율 증가 → 오프라인 NDCG는 감소하지만 온라인 지표는 개선

- 온라인 성과(ED, SF, CD)가 가장 좋은 지점의 w_s를 찾았음

- 위의 가설만 보면 그러면 무조건 영화보다 시리즈를 추천하는 게 온라인 지표에는 좋은 건가 싶은데, w_s를 너무 늘려도 ABT 결과가 떨어지는 걸 볼 수 있음

- 온라인 성과(ED, SF, CD)가 가장 좋은 지점의 w_s를 찾았음

+반대로 그러면 애초에 왜 낮은 w_s에서 오프라인 지표가 잘나왔던 건지?

- 영화는 단발성 소비(봤다/안봤다가 명확함). 시리즈는 1-2개 보고 이탈할 수도 있고, 이후에 연속적으로 시청하는 행위가 추천의 직접 결과로 보기도 애매해짐(라벨 관점에서 과소표현될 수 있음)

- 그렇기 때문에 오프라인에서는 모델이 영화 하나를 정확히 맞히는 게 시리즈 추천보다 점수가 높고, 온라인 입장에서는 시리즈 하나를 잘 골랐을 때 뒤따라오는 여러번/여러시간의 시청이 훨씬 큰 것

- 근데 결국 w_s라는 knob를 둬서 이거를 맞히고 여러개를 재학습해서 온라인 지표를 비교하는 비용을 들이는 건 약간 돌아가는 길처럼 느껴지긴 함.. 시리즈 추천에 적합하게 모델링할 수 있다면 그게 정답 같긴 한데, 어쨌든 현재 모델이 그걸 볼 수 없을 때 loss 바깥에서 통제할 수 있는 해결방법으로는 의미가 있을지도

- 여기서 영화/시리즈는 음악 도메인에서 음악/팟캐스트 같은 느낌인데 여러 컨텐츠 유형에 대한 랭킹 (Multinomial Blending) @Amazon Music 이것도 본질적으로는 같은 문제에 대한 해결책